Éthique de l'IA : Comment un développement responsable pourrait sauver l'avenir de l'humanité

À l’ère où l’intelligence artificielle transforme rapidement notre monde, l’importance du développement éthique de l’IA n’a jamais été aussi cruciale. Alors que nous naviguons à travers 2025, l’intersection de l’avancement technologique et de la responsabilité morale présente à la fois des opportunités et des défis sans précédent qui façonneront l’avenir de l’humanité.

Le fondement du développement responsable de l'IA

Le développement de l’intelligence artificielle doit reposer sur de solides principes éthiques qui donnent la priorité aux valeurs humaines, à la sécurité et aux avantages sociétaux. De récentes initiatives mondiales ont mis l’accent sur la nécessité d’un cadre global garantissant que les systèmes d’IA sont développés et déployés de manière responsable.

Principes clés de l'IA éthique

Transparence et responsabilité

- Documentation claire des systèmes d’IA

- Processus décisionnels traçables

- Audits et évaluations réguliers

Équité et non-discrimination

- Élimination des biais algorithmiques

- Égalité d’accès aux avantages de l’IA

- Représentation diversifiée dans les équipes de développement

Confidentialité et sécurité

- Mesures robustes de protection des données

- Consentement et contrôle de l’utilisateur

- Meilleures pratiques en matière de cybersécurité

Défis et solutions actuels

S'attaquer aux biais dans les systèmes d'IA

Des études récentes ont mis en évidence des schémas préoccupants de biais dans les systèmes d’IA. Selon le rapport d’ONU Femmes de février 2025, le biais sexiste reste un défi majeur dans les applications d’IA. Les organisations doivent s’employer activement à identifier et à éliminer ces biais par les moyens suivants :

- Données d’entraînement diversifiées

- Tests de biais réguliers

- Équipes de développement inclusives

- Consultation des parties prenantes

Éthique de l'IA médicale

Les lignes directrices du Forum économique mondial de janvier 2025 définissent quatre principes essentiels pour une IA responsable en médecine :

- Le bénéfice du patient comme objectif principal

- Transparence dans la prise de décision médicale

- Protection de la vie privée des patients

- Maintien de la supervision humaine

Cadre réglementaire mondial

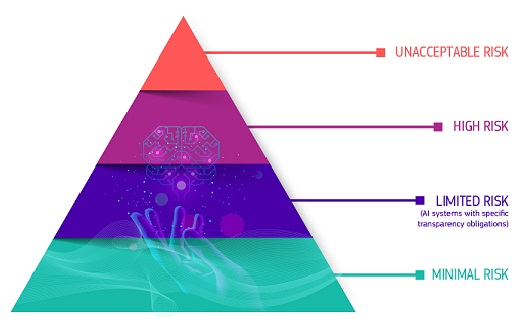

La loi européenne sur l'IA

L’Union européenne a joué un rôle de premier plan dans l’établissement d’une réglementation complète sur l’IA. Depuis février 2025, la loi sur l’IA propose une approche structurée pour :

- Catégorisation des risques des systèmes d’IA

- Exigences obligatoires pour les applications à haut risque

- Obligations de transparence

- Surveillance du marché

Le rôle de l'éducation et de la sensibilisation

Les initiatives éducatives jouent un rôle crucial pour garantir un développement responsable de l’IA. Des organisations comme MIT RAISE sont pionnières dans les programmes d’éducation à l’IA de la maternelle à la 12e année qui mettent l’accent sur :

- Considérations éthiques dans le développement de l’IA

- Compétences techniques alliées à des valeurs humanitaires

- Esprit critique sur les implications de l’IA

- Application pratique des principes d’une IA responsable

Responsabilité des entreprises

Les grandes entreprises technologiques adoptent de plus en plus des cadres éthiques complets. Le rapport 2024-2025 de Google sur l’IA responsable met l’accent sur :

- Principes de conception centrés sur l’utilisateur

- Durabilité environnementale

- Évaluation de l’impact social

- Suivi et amélioration continus

Considérations futures

Alors que nous nous tournons vers l’avenir, plusieurs domaines clés nécessitent notre attention :

Impact environnemental

- Systèmes d’IA écoénergétiques

- Pratiques informatiques durables

- Réduction de l’empreinte carbone

Impact social

- Adaptation du marché du travail

- Développement des compétences

- Égalité économique

Gouvernance

- Coopération internationale

- Établissement de normes

- Mécanismes d’application

Mesures pratiques à mettre en œuvre

Pour les organisations

- Créer des comités d’éthique

- Mettre en œuvre des audits réguliers

- Offrir une formation aux employés

- Dialoguer avec les parties prenantes

Pour les développeurs

- Suivre les directives éthiques

- Documenter la prise de décision

- Tenir compte de l’impact sociétal

- Maintenir la transparence

Pour les utilisateurs

- Rester informé

- Exiger la responsabilité

- Participer aux discussions

- Signaler les problèmes

Agir dès aujourd'hui

La voie vers un développement responsable de l’IA exige un effort et un engagement collectifs. En mettant en œuvre des cadres éthiques, en maintenant la transparence et en donnant la priorité aux valeurs humaines, nous pouvons garantir que les progrès de l’IA profitent à toute l’humanité.

Prêt à plonger plus profondément dans l’éthique de l’IA et le développement responsable ? Explorez nos cours et ressources complets sur 01TEK. Rejoignez une communauté de professionnels avant-gardistes déterminés à façonner un avenir éthique pour l’IA. Visitez notre site Web pour en savoir plus sur nos programmes spécialisés en éthique de l’IA et en développement responsable.

Sources :

My number one piece of advice is: you should learn how to program.

Mark Zuckerberg, founder of Facebook