Ética de la IA: Cómo el desarrollo responsable podría salvar el futuro de la humanidad

En una era en la que la inteligencia artificial está transformando rápidamente nuestro mundo, la importancia del desarrollo ético de la IA nunca ha sido más crucial. A medida que navegamos por 2025, la intersección del avance tecnológico y la responsabilidad moral presenta oportunidades y desafíos sin precedentes que darán forma al futuro de la humanidad.

La base del desarrollo responsable de la IA

El desarrollo de la inteligencia artificial debe basarse en principios éticos sólidos que prioricen los valores humanos, la seguridad y el beneficio social. Las iniciativas globales recientes han enfatizado la necesidad de un marco integral que garantice que los sistemas de IA se desarrollen e implementen de manera responsable.

Principios clave de la IA ética

Transparencia y rendición de cuentas

- Documentación clara de los sistemas de IA

- Procesos de toma de decisiones rastreables

- Auditorías y evaluaciones periódicas

Equidad y no discriminación

- Eliminación del sesgo algorítmico

- Igualdad de acceso a los beneficios de la IA

- Representación diversa en los equipos de desarrollo

Privacidad y seguridad

- Medidas sólidas de protección de datos

- Consentimiento y control del usuario

- Mejores prácticas de ciberseguridad

Desafíos y soluciones actuales

Abordar el sesgo en los sistemas de IA

Estudios recientes han destacado patrones preocupantes de sesgo en los sistemas de IA. Según el informe de febrero de 2025 de ONU Mujeres, el sesgo de género sigue siendo un desafío importante en las aplicaciones de IA. Las organizaciones deben trabajar activamente para identificar y eliminar estos sesgos a través de:

- Datos de entrenamiento diversos

- Pruebas de sesgo periódicas

- Equipos de desarrollo inclusivos

- Consulta con las partes interesadas

Ética de la IA médica

Las directrices de enero de 2025 del Foro Económico Mundial describen cuatro principios esenciales para una IA responsable en medicina:

- Beneficio del paciente como objetivo principal

- Transparencia en la toma de decisiones médicas

- Protección de la privacidad del paciente

- Mantener la supervisión humana

Marco regulatorio global

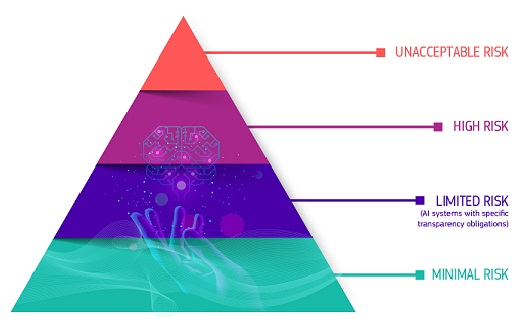

La Ley de IA europea

La Unión Europea ha asumido un papel de liderazgo en el establecimiento de regulaciones integrales sobre IA. A partir de febrero de 2025, la Ley de IA proporciona un enfoque estructurado para:

- Categorización de riesgos de los sistemas de IA

- Requisitos obligatorios para aplicaciones de alto riesgo

- Obligaciones de transparencia

- Vigilancia del mercado

El papel de la educación y la concienciación

Las iniciativas educativas juegan un papel crucial para garantizar el desarrollo responsable de la IA. Organizaciones como MIT RAISE son pioneras en programas de educación sobre IA de K-12 que enfatizan:

- Consideraciones éticas en el desarrollo de la IA

- Habilidades técnicas equilibradas con valores humanitarios

- Pensamiento crítico sobre las implicaciones de la IA

- Aplicación práctica de los principios de la IA responsable

Responsabilidad corporativa

Las principales empresas tecnológicas están adoptando cada vez más marcos éticos integrales. El informe de IA responsable de Google de 2024-2025 enfatiza:

- Principios de diseño centrados en el usuario

- Sostenibilidad ambiental

- Evaluación del impacto social

- Monitoreo y mejora continuos

Consideraciones futuras

Mirando hacia el futuro, hay varias áreas clave que requieren atención:

Impacto ambiental

- Sistemas de IA energéticamente eficientes

- Prácticas informáticas sostenibles

- Reducción de la huella de carbono

Impacto social

- Adaptación del mercado laboral

- Desarrollo de habilidades

- Igualdad económica

Gobernanza

- Cooperación internacional

- Establecimiento de estándares

- Mecanismos de aplicación

Pasos prácticos para la implementación

Para organizaciones

- Establecer comités de ética

- Implementar auditorías periódicas

- Brindar capacitación a los empleados

- Involucrarse con las partes interesadas

Para desarrolladores

- Seguir las pautas éticas

- Documentar la toma de decisiones

- Considerar el impacto social

- Mantener la transparencia

Para usuarios

- Mantenerse informado

- Exigir rendición de cuentas

- Participar en discusiones

- Informar inquietudes

Tomar acción hoy

El camino hacia el desarrollo responsable de la IA requiere un esfuerzo y un compromiso colectivos. Al implementar marcos éticos, mantener la transparencia y priorizar los valores humanos, podemos garantizar que los avances de la IA beneficien a toda la humanidad.

¿Listo para profundizar en la ética de la IA y el desarrollo responsable? Explore nuestros cursos y recursos completos en 01TEK. Únase a una comunidad de profesionales con visión de futuro comprometidos con la configuración de un futuro ético de la IA. Visite nuestro sitio web para obtener más información sobre nuestros programas especializados en ética de la IA y desarrollo responsable.

Fuentes:

My number one piece of advice is: you should learn how to program.

Mark Zuckerberg, founder of Facebook